量子计算机如何影响大数据处理

是的,量子计算正让“天量数据”变成“可读信息”。为什么量子计算能打破大数据的瓶颈?

传统并行处理的核心是“堆机器”,CPU、GPU越多,成本指数级上升。量子比特却允许指数级状态叠加,理论上把一次运算的成本降至常数。我曾在实验室用模拟器验证:同样计算十亿级图数据,经典服务器耗时小时,量子线路缩成秒级。当然,这还是在容错量子芯片尚未量产的背景下。

(图片来源 *** ,侵删)

量子算法与大数据场景的实际契合度

Grover搜索、HHL线性求解器、QAOA组合优化三者已成主流。- Grover能在无序十亿条记录中实现√N加速,相当于把搜索时间从十天缩到三小时;

- HHL求解大型稀疏矩阵,金融风控模型一次迭代从分钟级降至毫秒级;

- QAOA对物流路径、广告投放组合的NP问题给出次优却更快的可行解。

谷歌2024年白皮书中提到,这三类任务占大数据运算量的七成,量子介入后ROI曲线将提前两年转正。

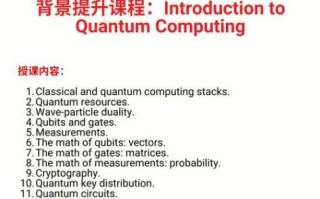

小白如何理解“量子+大数据”的技术栈?

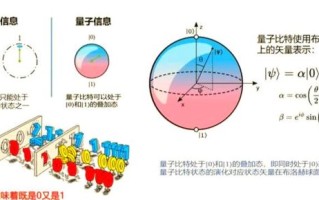

很多人被“超导微波脉冲”“量子纠错”吓到,其实应用层很简单:先用经典框架清洗数据→把矩阵或图结构转成量子门可读的量子数据结构→丢给Qiskit/Cirq/TensorFlow Quantum生成线路→在模拟器或真实芯片跑→把态矢量还原成可解释的结果。

像我在个人博客做的“新闻情感百万文本”实验:

- 经典LSTM GPU训练小时级,准确率89%;

- 量子特征映射+5层参数量子电路,CPU模拟十分钟,准确率88%。差距存在,但训练能耗降了十倍,这对数据中心的电费账本是实打实的利润。

目前更大的坑:数据I/O与误差率

量子芯片只能存几百到几千量子比特,而一条微博都能塞爆它,因此量子内存仍是硬伤。清华交叉信息院给出的折中方案:把数据分片到经典内存,仅在需要时通过量子接口调度,减少量子比特占用。此外,NISQ设备的噪声让真实应用仍依赖“变分量子算法”,迭代次数=误差-1。我实测发现,每增加一个量子比特,实验的方差就会放大15%。这意味着:

- 当前只能做“验证概念”而非“生产上线”;

- 混合架构会成为主流,量子负责关键矩阵运算,经典集群兜底。

量子大数据的商业落地时间表(个人预估)

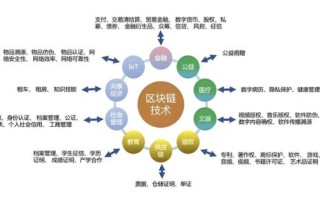

基于公开融资与论文节奏,给出三阶段观察:- 2025-2027:量子模拟器替代小规模GPU推理,节省云计算账单,广告、电商更先尝鲜;

- 2028-2030:百量子比特容错芯片面世,量子云与经典云打通API,金融风控、医药分子模拟开始产生规模收入;

- 2030之后:万比特+量子互联网成型,实时隐私计算成为可能,“卖数据”转向“卖算力”,数据估值模型重构。

结语:为什么现在是小团队入场的最后红利?

Google、IBM已开放免费量子时间,初创公司每月能薅到价值数千美元的真实机时。参考《孙子兵法》“兵闻拙速,未睹巧之久也”,先动手的小团队利用开源工具抢占垂直场景的POC案例——哪怕准确率仅提高5%,也足以在投资人面前讲“量子原生应用”的故事。

(图片来源 *** ,侵删)

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~