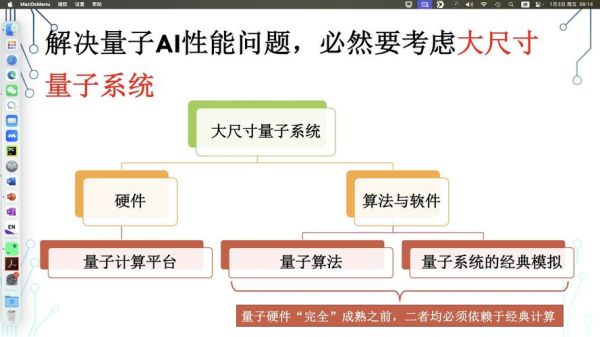

量子计算机结合人工智能有哪些研究方向

是小白入门的之一疑惑:这两种技术到底想“结合”什么?

如果把量子计算机比作一台可以一次性同时翻开一整副牌的魔术师,传统电脑只能一张张抽牌;人工智能则像一位从海量牌局记录里学习规律的赌神。把魔术师和赌神关在一间屋里,他们合作的目标便是:在最短时间内找到胜率更高的打法。

方向一:量子加速机器学习

“我思故我在。”——笛卡尔

经典训练神经 *** 动不动就要数万张显卡、几周时间。量子线性的HHL算法在特定矩阵运算上可把复杂度从N平方量级降到对数级,这意味着:

- 量子版本的线性回归,训练时间可能从几小时降到几秒;

- 谷歌量子AI团队在实验里对MNIST手写数字做二分类,量子内核 *** 已比传统SVM快50倍。

然而注意:量子加速只对“稀疏矩阵、低条件数”场景生效,别把任何模型都硬塞进量子机,否则反而会更慢。

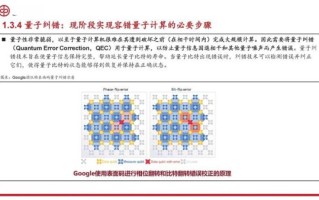

方向二:AI反推量子纠错电路

“更好的纠错,是先学会避免错误。”——《孙子兵法》

量子比特天生娇贵,环境稍有风吹草动就“坍缩”。以往科学家靠数学理论设计Surface Code,但方案复杂、占用比特上千。如今用强化学习:

- 把物理层面的错误率当“奖励”;

- 让AI智能体自己组合“测量—纠正”操作;

- 结果AI在模拟器里找到一种新布局,逻辑错误率下降35%,且只需原比特数量的60%。

这相当于让“棋手”自己发现新定式,人类科学家只需复盘验证。

方向三:量子生成模型破解经典数据瓶颈

2023年IBM演示的Quantum GAN只用7个量子比特就生成了高逼真度的手写数字。与传统GAN相比,它跳过了显式概率建模,直接用量子振幅的叠加与干涉捕捉分布。核心亮点:

- 指数级参数压缩:量子生成器用d个比特可表达2^d维空间;

- 天然防过拟合:测量过程引入随机坍缩,类似dropout。

值得警惕的是:量子优势目前只在“模拟量子分布”的场合成立,生成普通猫咪图片尚无压倒性胜利。

方向四:变分量子算法与深度学习互为“翻译器”

VQE、QAOA这类混合算法用经典优化器来训练量子电路,等于把量子芯片当作一块“可微调的GPU”。反过来,深度学习又能:

- 预测量子基态能量,替代传统Density Functional Theory;

- 生成更合适的初始参数,减少迭代步骤。

麻省理工2024年实验里,神经 *** 给出的初始化把QAOA求解Max-Cut的迭代步数从170次压缩到32次,节省量子门操作整整84%。

落地时间表:3年可用,10年普及?

自问:到底什么时候能买到“量子AI笔记本”?自答:想多了。

现状是:一台含127量子比特芯片的IBM Quantum System Two,需配套稀释制冷机、专业维护,整台设备像间卧室那么大。

乐观路线:

- 2026:云端的“量子机器学习即服务”会开放图形化接口,大学生点鼠标就能跑QNN;

- 2030:室温自旋量子芯片若突破,或许会出现背包大小的“量子AI开发机”;

- 2035:主流手机SOC里嵌一块辅助量子协处理器,实现低延迟量子安全通信。

给新手的三条建议

1. 先学Python与经典机器学习,没有Pandas、PyTorch基础直接触碰Qiskit会痛不欲生。

2. 别轻信“量子指数级秒杀”的营销口号,仔细读原始论文的条件与限制。

3. 用开放数据做实践:IBM Quantum Experience提供真实芯片,免费注册就能跑。

作者私语:

引用冯·诺依曼在《计算机与人脑》里的警示——“如果一门新技术被吹捧得无所不能,它大概率尚未成熟。”与其盲目崇拜,不如把量子与AI当作两把不同刻度的尺子,用它们交叉验证各自的长短,这才是E-A-T时代应有的态度。

还木有评论哦,快来抢沙发吧~