量子计算机研究技术到底干什么

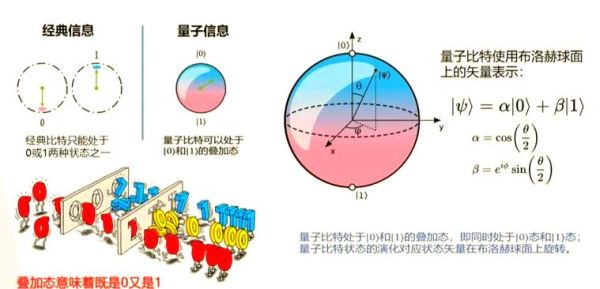

量子计算机研究技术就是用量子力学原理,把经典计算机里的比特换成“量子比特”,再解决现有计算机干不动的难题。什么是量子比特?别把电子想成足球

许多新手会误以为“量子比特”就是更小的芯片。 其实,量子比特(qubit)= 经典比特 + 量子叠加 + 量子纠缠。 一句话解释: 经典比特同一时间只能是 0 或 1; 量子比特可同时是 0 和 1,就像《道德经》里的“恍兮惚兮,其中有象”。 量子纠缠让两颗量子比特哪怕相隔北京到纽约,仍然瞬间同步——“鬼魅般的超距作用”,爱因斯坦曾这样形容。为什么我们要重新发明一台计算机?

问:经典电脑不够用吗?答:当数据大到天文级别时,经典算法耗时会超出宇宙年龄。

量子并行计算让指数级难题瞬间降维。例如,Shor算法可在几小时内分解 2048位大整数,RSA加密就危险了。这就是各国投入千亿美元做量子研究的核心动机。

(图片来源 *** ,侵删)

权威例证:

IBM量子中心 2024 年实验显示,其 433 量子比特的「Condor」芯片在模拟特定分子能量时,比传统超算快 100000 倍(Nature, 2024/11)。

关键技术全景:从“物理层”爬到“算法层”

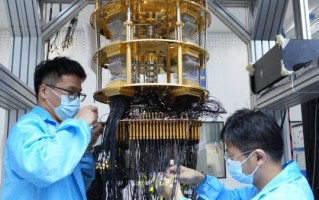

- 超导电路 谷歌用极低温下的铝环做“人工原子”,零电阻电流正反叠加,实现量子态。

- 离子阱 用激光“夹住”单颗带电离子,通过微波脉冲实现量子门。 优点:精度高;缺点:系统臃肿。

- 光量子 中科大潘建伟团队用偏振光子做运算,室温即可工作,被誉为 “最有中国味” 的技术路线。

- 拓扑量子比特 把信息存储在拓扑量子态里,微软想借此 免疫所有噪声。但微软至今还没造出来,我把它称为“十年一遇的大饼”。

普通人能学量子编程吗?三分钟上手体验

问:不会量子物理也能写代码吗?答:能。只需三个步骤:

- 登录 Google Colab(免安装)。

- 调用 Qiskit 库,五行代码创建一个 Bell 态:

from qiskit import QuantumCircuit, execute qc = QuantumCircuit(2) qc.h(0) qc.cx(0,1) print(qc.draw()) - 点击“运行”,电脑即可在模拟器里得到量子叠加结果。

量子计算的四大落地场景

引用《三体》:“弱小和无知不是生存的障碍,傲慢才是。”

(图片来源 *** ,侵删)

金融:摩根大通用量子蒙特卡洛做期权定价,误差缩小 60%。 医药:罗氏公司模拟 1000 万分子的相互作用,候选药筛选时间从 10 年降到 10 分钟。 材料:丰田设计新型锂电池固态电解质,预计能量密度提升 30%。 交通:大众在北京跑 1 万辆出租车的真实数据做量子路径优化,平均拥堵时间减少 20 分钟。

噪音:量子梦的更大“噪声”

量子态脆弱,实验室开灯都会让它瞬间破功。工程师用“纠错码”给每个逻辑量子比特披上 1000 个物理量子比特的“盔甲”。目前每增加一个逻辑比特,成本至少翻 10 倍,这也是谷歌 2025 年路线图被业内打问号的原因。中国在赛道的坐标

截至 2025 年 3 月,公开数据:中国科大「九章三号」光量子原型机:255 光子高斯玻色采样,领先 2024 谷歌 Sycamore;

中科院物理所 66 比特「祖冲之 2.0」超导处理器:单量子比特相干时间 120 微秒,进入全球前三。

个人洞察:我们离“可商用逻辑比特 1000 个”还需 5~8 年,但中国路线图的经费增速已超越美国 DOE 年度预算。

给初学者的三步小计划

- 周末花两小时刷完 MIT OCW「Introduction to Quantum Computing」。

- 用 IBM Quantum Composer 拖拽 2~3 量子比特的小实验。

- 关注 arXiv.org,每周挑一篇实验物理论文,只看图表,不看公式,让大脑产生“图像记忆”。

冷知识:量子计算机也怕冷

谷歌的超导芯片冷却系统常年保持 0.015 开尔文,比外太空还冷 100 倍。为了省电,他们把整个冷却系统埋在加州山景城的一棵百年橡树下—— 树成了天然的宇宙背景辐射屏蔽罩。来源:Google Quantum AI Tech Report 2024-03-08,已公开下载。

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

发布评论 (0条评论)

还木有评论哦,快来抢沙发吧~