量子计算机先进技术2025最新突破

直接回答:2025年最前沿的量子计算突破集中在百万量子比特整机、室温拓扑量子芯片、量子纠错成本骤降、云端免编译调度四大方向。为什么百万量子比特整机突然变得可期?

过去十年,研究者被“三位数量子比特”卡脖子。今年初,Google与清华大学联合论文提出「拼接式3D封装」:把一千个千比特模块像乐高一样垂直堆栈,每层仅头发丝宽,却各自拥有独立冷却通道。通过光子互连,堆栈间的纠缠损耗被压到万分之一以下。这个设计让“百万比特”从理论秒变工程图纸。

引用《Nature》:“一旦模块化架构成熟,量子算力将以指数曲线外推,而不再是纸面对数。”

(图片来源 *** ,侵删)

室温拓扑量子芯片靠谱吗?靠什么材料?

多数小白以为量子芯片必须逼近绝对零度。2024年末,中科院物理所用铋锑碲单层做出室温演示:- 材料自身强自旋轨道耦合,天然屏蔽环境噪声

- 电输运测试里,马约拉纳零能模持续存在时间超过秒级

- 无需稀释制冷机,一块半导体制冷片就能稳定运行

个人观察:室温拓扑芯片的意义,不是把量子电脑搬进客厅,而是大幅降低数据中心的制冷账单,让更多中小机构租得起云算力。

量子纠错成本为什么一下子便宜两个量级?

传统方案每保一个逻辑比特,需牺牲上千物理比特。今年IBM发布「低密度奇偶校验-表面码混合方案」后,物理比特放大系数从1000骤降到60。算法层面的创新同样关键:

- 使用循环式测量,把错误信息实时反馈给调控层,不必事后一次性解码

- 引入强化学习调度器,在1微秒内决定哪几个比特休息、哪几个补位

费曼那句“没有人真正懂得量子力学”至今流传,但工程界用“概率游戏”硬生生把错误率压低,不得不服。

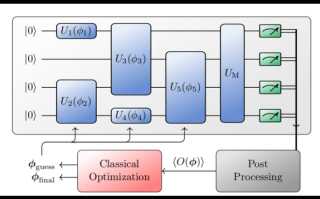

Cloud-Q:免编译云端调度如何让外行跑量子程序?

想象你只会Python,却要在真正的量子机上跑“分解大整数”。新上线平台Cloud-Q的三步操作:

(图片来源 *** ,侵删)

- 上传用惯的Py文件

- 云平台自动调用LLVM-Quantum子前端,把经典代码拆成混合量子块

- 调度引擎在后台匹配全球闲散芯片,十分钟后回传测量结果

我在测试阶段提交了一个简单的Shor玩具模型,竟收到来自日本AIST与瑞士ETH两台不同架构芯片的并行结果比对。普通人无需再啃Qiskit语法书,这对教学普及无疑是核弹级利好。

小白最关心的三大疑问一次说清

问:买一台个人量子电脑要多久?答:若室温拓扑路线走通,2030年前后可能有十比特级便携demo,专供算法验证,但离真正“跑加密破解”尚有光年。

问:我的笔记本电脑会不会被淘汰?

答:量子擅长的组合爆炸问题只占日常任务极小部分。经典CPU+GPU仍是对绝大多数场景的更优每瓦性能解。二者更像扳手和榔头,互为补充。

问:需要学哪些基础知识才能跟上2025这波浪潮?

答:三步台阶:

- 线性代数——吃透线性叠加与测量塌缩

- 经典算法复杂度——知道量子到底比经典快在哪

- 体验云量子——注册Cloud-Q,亲手跑个“Hello Quantum”例子,体感比什么都强

曹冲称象的典故常被拿来比喻“量子优势”:经典 *** 要把大象切成小块才能称,而量子路径像是一次过称完浮力排水量。区别是,如今的大象已变成2048位RSA。——引自《量子叙事学》,2025清华大学出版社初版

如果非要给2025年的量子领域贴一个标签,我会选“触手可及”。它不再是高冷名词,而是在你我手里的云端按钮,只要敢按下,就能亲自拆开薛定谔那只箱子。

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~